|

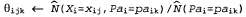

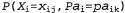

Страница 3 из 3 Логарифмическое правдоподобие данных возрастает от первоначального значения, примерно равного -2 044, приблизительно до -2021 после первой итерации, как показано на рис. 20.9, б. Это означает, что в данном обновлении само значение правдоподобия улучшается примерно на коэффициент . К десятой итерации модель, полученная в процессе обучения, лучше согласуется с данными, чем первоначальная модель (L=-1982.214). Но дальнейший прогресс очень сильно замедляется. Такая ситуация в приложениях алгоритма ЕМ встречается весьма часто, поэтому во многих практически применяемых системах алгоритм ЕМ на последнем этапе обучения используется в сочетании с таким алгоритмом на основе градиента, как алгоритм Ньютона—Рафсона (см. главу 4). . К десятой итерации модель, полученная в процессе обучения, лучше согласуется с данными, чем первоначальная модель (L=-1982.214). Но дальнейший прогресс очень сильно замедляется. Такая ситуация в приложениях алгоритма ЕМ встречается весьма часто, поэтому во многих практически применяемых системах алгоритм ЕМ на последнем этапе обучения используется в сочетании с таким алгоритмом на основе градиента, как алгоритм Ньютона—Рафсона (см. главу 4). Общий вывод, который может быть сделан на основании данного примера, состоит в том, что обновления параметров при обучении байесовской сети со скрытыми переменными являются непосредственно доступными из результатов вероятностного вывода по каждому примеру. Более того, для каждого параметра требуются только локальные апостериорные вероятности. Для общего случая, в котором в процессе обучения определяются параметры условной вероятности для каждой переменной , если даны ее родительские переменные (иначе говоря, , если даны ее родительские переменные (иначе говоря, ), обновление задается с помощью нормализованных ожидаемых количеств следующим образом: ), обновление задается с помощью нормализованных ожидаемых количеств следующим образом:

Эти ожидаемые количества можно получить путем суммирования по всем примерам и вычисления вероятностей для каждого из них с использованием любого алгоритма вероятностного вывода в байесовской сети. Для использования в точных алгоритмах (включая алгоритмы удаления переменных) все эти вероятности могут быть получены непосредственно как побочный продукт стандартного вероятностного вывода, без необходимости применения дополнительных вычислений, характерных для обучения. Более того, информация, необходимая для обучения, доступна локально применительно к каждому параметру. для каждого из них с использованием любого алгоритма вероятностного вывода в байесовской сети. Для использования в точных алгоритмах (включая алгоритмы удаления переменных) все эти вероятности могут быть получены непосредственно как побочный продукт стандартного вероятностного вывода, без необходимости применения дополнительных вычислений, характерных для обучения. Более того, информация, необходимая для обучения, доступна локально применительно к каждому параметру.

<< В начало < Предыдущая 1 2 3 Следующая > В конец >>

|